Hace ya un par de años, Ars Technica publicaba: « Los cerdos de la banda ancha» (bandwidth hogs) viven en el reino de las criaturas míticas, junto con los unicornios».

Que quede claro que la expresión no es nuestra y que bandwidth hog es un término que emplean los anglosajones para referirse a los usuarios que consumen más banda ancha que el resto. El reportaje de Ars Technica recogía una hipótesis de Benoît Felten, consultor de Diffraction Analysis, sobre lo que ocurre con los data caps.

Según Benoît Felten, los límites al consumo de banda ancha que ponen los operadores, bajo la excusa de que unos pocos usuarios consumen la mayoría de los recursos de la red, no necesariamente alivian la congestión de la red. Para demostrar su hipótesis pidió la colaboración de ISPs que quisieran participar en su estudio y, de paso, comprender mejor cómo funcionaban sus redes. Un operador americano, Sonic.net accedió a participar en su experimiento.

¿Son los caps el camino para acabar con la saturación?

Sonic dice que no cree que los data caps sean necesarios y que si la congestión es el problema, los límites son una forma errónea de abordarla durante las horas pico, cuando la red va lenta para todos.

De hecho, según Sonic.net, lo de los data caps tiene más que ver con otras cosas:

«Los caps poco tienen que ver con aspectos técnicos, la razón fundamental de poner topes en el consumo de banda ancha es prevenir la ruptura del modelo de negocio de la televisión de entretenimiento que alimenta las pantallas de TV en la mayoría de las casas»

¿Penalizan los data caps a los usuarios equivocados?

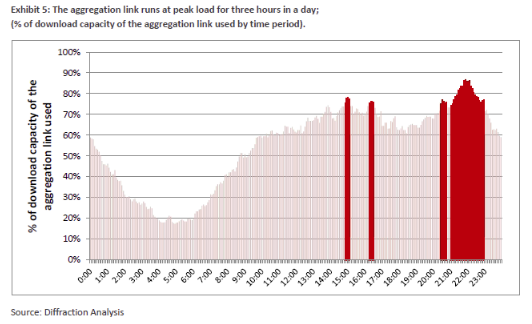

El estudio de Felten, después de estudiar los patrones de consumo de los usuarios de Sonic.net, arrojó estas conclusiones:

**Los datos del estudio son de uso real de todos los consumidores de banda ancha conectados a un único punto de agregación y las estadísticas son del consumo de datos en la red en incrementos de cinco minutos durante un día entero.

- El 1% de los usuarios que consumen más datos (very heavy consumers) representan el 20% del consumo total

- La media de consumo de datos durante el periódo es de 290 MB, mientras que el consumo de los very heavy consumers es de 9,6 GB. Esto equivale a un consumo medio mensual de 8,7 GB y 288 GB mensuales respectivamente.

- En todo caso, solo la mitad de esos very heavy consumers tienen contratado un servicio de 6 Mbps, lo que significa que la otra mitad de los heavy users tiene el ancho de banda restringido a 3 Mbps o incluso menos.

- El 61% de los heavy users (en consumo de datos) se descarga cosas el 95% del tiempo. Sin embargo, de todos los usuarios que se descargan cosas el 95% del tiempo, únicamente son heavy users un 5%.

- Mientras que el 83% de los heavy users están entre el 1% de los usuarios que más banda ancha consumen durante al menos un periodo de cinco minutos en hora pico (el estudio se centra en el análisis del comportamiento de la red en periodos de cinco minutos), sobre el total del 1% de los usuarios que más consumen solo un 14,3% son heavy data users.

- La proporción de ancho de banda que corresponde a los very heavy users disminuye cuando el tráfico en el punto de conexión está por encima del 75%, es decir los heavy users no están copando los recursos de la red.

- El 42% de todos los usuarios están entre el 10% de los usuarios que más consumen durante las horas pico.

Conclusiones de los afectados

Con todos estos datos, en IP Carrier sugieren que si en realidad los data hogs no son los que causan la congestión, es más lógico pensar en utilizar otras formas de tarificar y otros precios para modificar la demanda. La cuestión es saber si otros esquemas que podrían funcionar son aceptables para los usuarios y los ISP.

Sonic.net sostiene que ellos no hacen gestión del tráfico y que cuando hay congestión amplían la capacidad de sus conexiónes. Sin embargo, señalan que si hay que hacer algúna gestión, por ejemplo, ralentizar la conexión de quién esté consumiendo más hasta el nivel del siguiente usuario que esté consumiendo más en el momento específico de congestión, sería una política más razonable.

Congestión de la red, perfiles de consumo de usuarios y modelos de negocio de los ISP, en @cmtblog http://t.co/gjk1H3UT

Data caps ¿pagan justos por pecadores? http://t.co/TNQl109h via @cmtblog

Data Caps ¿pagan justos por pecadores? – CMT http://t.co/g8e5rAJY #BandaAncha #Broadband #in

El límite de capacidad no es tan importante en redes fijas, ya que. p.ej. en ADSL la línea es dedicada para cada usuario y desde la central están las fibras. Es muy importante en redes móviles donde el acceso es compartido por todos los usuarios de la célula y la inversión está en relación directa con la capacidad. Además, en estaciones base con transmision por radioenlace, también la capacidad requiere inversión.

Hola Cayetano,

Sí, de hecho este estudio está hecho con datos de un ISP de EEUU, donde allí algunos los operadores de red fija ponen caps a sus planes. Sin embargo, en móvil es aún más frecuente que ocurra esto, como en el caso de España.

Saludos,

Mercedes

Personalmente no estoy de acuerdo con el análisis. Es cierto que las congestiones se dan en horas pico y por lo tanto en su ocurrencia contribuyen «todos» los usuarios de la red pero no es menos cierto que los «heavy users» suelen tener un perfil de «chupa todo el ancho de banda que puedas todo el tiempo que esté disponible» por lo que en la práctica representan que, del dimensionamiento de un operador, una porción proporcionalmente grande (si consideramos el número de usuarios) esta dedica constantemente a servirlos (el famoso 20% de los recursos). El resultado es que obligan a sobredimensionar recursos. Es una realidad impepinable que si los heavy users se comportasen «como el resto» los operadores podrían servir a los mismos usuarios con menos recursos.

Más aún, TCP es un protocolo que, en caso de congestión, distribuye el tráfico de modo igualitario entre todos los circuitos virtuales no usuarios. Por eso, aunque el ancho de banda que «tragan» los heavy users durante los peak rates disminuye, como emplean programas de descarga que usan múltiples conexiones TCP (si lo comparamos que un usuario que sólo este navegando o viendo un vídeo en streaming por ejemplo) estos usuarios siguen acaparando más de lo que les «correspondería». Siempre y cuando no haya ningún tipo de gestión selectiva de la red claro está. Por eso personalmente sí creo que los límites de tráfico funcionan a la hora de atacar el problema de la congestión de red, sobre todo porque, haya los límites que haya los heavy users siempre se van a comportar igual: consumen todo lo que pueden todo el tiempo que pueden y si les limitas el tráfico consumen menos picos incluídos, así de simple.

Hola Manchitas,

Gracias por compartir tu visión del problema de los heavy users. En el post recogemos el análisis que hace el consultor Benoît Felten sobre el tema con los datos de un operador concreto.

saludos

Lo se y os lo agradezco muchisimo, no tenía ni idea de este interesante estudio. Se agradece que mantengais tan activo este blog, muchas gracias y a seguir con vuestra labor, creo que en la CMT hay grandísimos profesionales.

Tampoco es mi intención invalidar la opinión de dicho consultor pero existen puntos en los que discrepo respecto de su análisis el cual, por otra parte, parece partir del presupuesto que se pretende probar (una mala costumbre en ciencia).

Manchitas,

Gracias por tus aportaciones. Sabemos que eres asiduo del blog y tus comentarios enriquecen el debate. Lo interesante de todo esto es ver que hay estudios que rebaten una teoría, introducen una visión crítica sobre un aspecto. Por eso lo recogemos en el blog…

Lo interesante ahora podría ser ver qué pasa con el tráfico y los heavy users con el cierre de Megaupload… Estaremos atentos.

Saludos,

Mercedes

[…] Felten, consultor de Diffraction Analysis, realizó un estudio (recogido por CMT blog) con la colaboración de un proveedor americano que reveló interesantes conclusiones. En primer […]